Créer une chanson juste en écrivant une phrase comme « Une mélodie triste au piano dans un style classique » ? Cela semblait encore de la science-fiction il y a quelques années. Pourtant, c’est désormais possible grâce à Text2Midi, un modèle d’intelligence artificielle (IA) capable de générer de la musique à partir de descriptions textuelles.

Ce projet, mené par des chercheurs de Queen Mary University of London et de la Singapore University of Technology and Design, propose une solution innovante et intuitive pour créer de la musique. Voici comment cela fonctionne et pourquoi c’est une avancée majeure dans le domaine de la création musicale assistée par IA.

Un générateur de musique à partir de texte

Text2Midi repose sur un principe simple à comprendre : tu écris ce que tu veux entendre, l’IA le compose.

Par exemple, tu peux écrire :

« Un morceau rapide et joyeux avec guitare électrique, batterie et basse, en La majeur, inspiré du rock des années 80. »

Et l’algorithme va générer un fichier MIDI, un format numérique utilisé en musique pour représenter les notes, les instruments, le rythme, etc. Ce fichier peut ensuite être lu ou modifié dans n’importe quel logiciel de musique (comme Ableton Live, Logic Pro, GarageBand, etc.).

Mais derrière cette simplicité apparente, le système repose sur une architecture complexe d’intelligence artificielle.

Comment ça fonctionne ?

Text2Midi utilise un modèle de type encodeur-décodeur, largement utilisé dans le traitement du langage naturel. En clair, il y a deux grandes étapes :

- Comprendre le texte

L’IA utilise un modèle appelé FLAN-T5, un grand modèle de langage déjà entraîné à comprendre des consignes en langage naturel. Il va extraire le sens de ta phrase : l’ambiance, les instruments, le tempo, la tonalité… - Générer la musique

Ensuite, un transformeur spécialisé (une sorte de cerveau d’IA utilisé aussi dans ChatGPT ou les modèles de génération d’images) va composer la musique, note après note, selon les consignes comprises.

Pour représenter la musique, le système utilise un encodeur MIDI appelé REMI+, qui transforme les fichiers musicaux en séquences de “mots musicaux” (tempo, note, durée, instrument…), un peu comme des phrases musicales.

Un entraînement en deux temps

Comme tout modèle de deep learning, Text2Midi a besoin de beaucoup de données pour apprendre.

1. Pré-entraînement avec SymphonyNet

Les chercheurs ont utilisé un grand ensemble de morceaux orchestraux (46 000 fichiers MIDI) appelés SymphonyNet. Comme ces fichiers n’ont pas de descriptions associées, ils ont créé des “légendes automatiques” avec des phrases types comme :

« Morceau en 4/4, en Si mineur, à 114 BPM, avec flûte, hautbois et violon. »

L’IA apprend ainsi à relier des éléments musicaux à des mots.

2. Affinage avec MidiCaps

Ensuite, le modèle est affiné avec MidiCaps, une base de données plus récente contenant 168 000 fichiers MIDI, cette fois accompagnés de descriptions riches (style, émotion, instrumentation…). C’est cette phase qui permet à Text2Midi de mieux capter des nuances plus subtiles dans les textes.

Mieux que les autres modèles ?

Oui, et les résultats le prouvent.

Text2Midi a été comparé à MuseCoco, un autre modèle capable de générer de la musique à partir de texte, mais avec une approche en deux étapes (texte → attributs musicaux → musique). Text2Midi est direct et plus rapide, et surtout, plus fidèle aux consignes.

Des évaluations ont été réalisées de deux façons :

- Objectivement, via des mesures comme la fidélité au tempo, à la tonalité, et la structure répétitive (compression ratio).

- Subjectivement, via une étude d’écoute auprès de participants.

Résultat ? Text2Midi s’est démarqué par :

- Une meilleure qualité musicale perçue.

- Une plus grande fidélité aux descriptions (style, humeur, tempo, accords…).

- Une vitesse de génération deux fois plus rapide.

Limites et perspectives

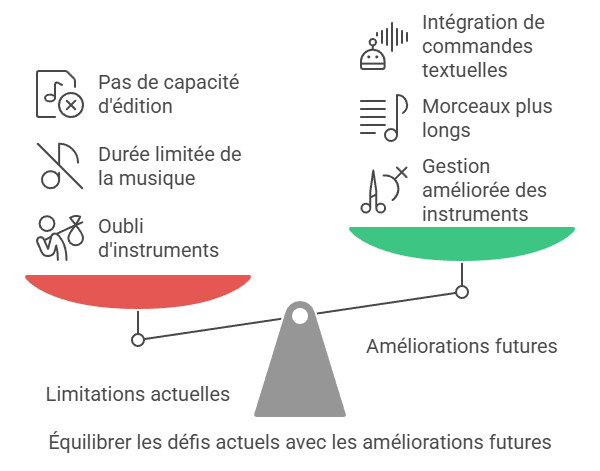

Text2Midi est une avancée impressionnante, mais il n’est pas parfait.

Par exemple, il peut oublier certains instruments mentionnés dans la description, surtout s’ils interviennent tard dans un morceau. De plus, les fichiers générés durent pour l’instant environ 40 secondes, ce qui peut être court selon les usages.

Les chercheurs envisagent déjà des pistes pour l’améliorer :

- Meilleure gestion des instruments complexes.

- Possibilité de générer des morceaux plus longs.

- Intégration de commandes textuelles pour éditer la musique générée (“ralentis le tempo à la fin”, “remplace la guitare par un violon”, etc.).

Une révolution créative

Avec Text2Midi, la création musicale devient plus accessible, intuitive et rapide. On n’a plus besoin de savoir lire une partition ou jouer d’un instrument pour exprimer ses idées musicales. Il suffit de savoir les formuler avec des mots.

Cela ouvre la porte à de nombreux usages :

- Compositeurs en herbe ou confirmés.

- Créateurs de contenus.

- Enseignants en musique.

- Artistes en quête d’inspiration.

C’est aussi un excellent outil pour explorer le lien entre langage et musique, deux formes d’expression qui sont peut-être plus proches qu’on ne le pense.

Text2Midi, en reliant texte et musique, redéfinit la manière dont on compose. En unifiant les mondes du langage et du son, il propose une nouvelle façon de créer, où l’imagination s’écrit en mots et se joue en musique.

Plus d’informations :

Text2Midi : quand les mots deviennent musique

Text2Midi : quand les mots deviennent musique La mélodie des songes : Comment la musique influence nos rêves

La mélodie des songes : Comment la musique influence nos rêves Les meilleures bandes sonores de jeux vidéo : un voyage à travers des compositions inoubliables

Les meilleures bandes sonores de jeux vidéo : un voyage à travers des compositions inoubliables Frédéric Chiu : Un innovateur révolutionnant l’enseignement musical à l’Université Carnegie Mellon

Frédéric Chiu : Un innovateur révolutionnant l’enseignement musical à l’Université Carnegie Mellon Les innovations dans la fabrication des instruments à vent

Les innovations dans la fabrication des instruments à vent Pourquoi certaines musiques nous donnent-elles envie de danser ?

Pourquoi certaines musiques nous donnent-elles envie de danser ? L’éducation musicale : enjeux sociaux et cognitifs

L’éducation musicale : enjeux sociaux et cognitifs Fabrication de disque vinyle : un processus en 6 étapes

Fabrication de disque vinyle : un processus en 6 étapes Quels sont les violons les plus chers jamais vendus

Quels sont les violons les plus chers jamais vendus L’essentiel pour créer le son shoegaze parfait : pédales, plugins, et techniques de mastering

L’essentiel pour créer le son shoegaze parfait : pédales, plugins, et techniques de mastering